|

| Настройки blogspot.com |

В блоггере он называется Custom Robots.txt, что означает, что теперь вы можете настроить этот файл по своему выбору.

В сегодняшнем уроке мы подробно обсудим этот термин и узнаем о его использовании и преимуществах. Я также расскажу вам, как добавить собственный файл robots.txt в блоггер.

Итак, давайте начнем руководство.

Что такое Robots.txt?

Robots.txt представляет собой текстовый файл , который содержит несколько строк простого кода.

Он сохраняется на веб-сайте или на сервере блога, который инструктирует сканеров о том, как индексировать и сканировать ваш блог в результатах поиска.

Это означает, что вы можете ограничить любую веб-страницу в своем блоге поисковыми роботами, чтобы она не могла быть проиндексирована в поисковых системах, таких как страница с метками блога, демонстрационная страница или любые другие страницы, которые не так важны для индексации.

Всегда помните, что поисковые роботы сканируют файл robots.txt перед сканированием любой веб-страницы.

Каждый блог, размещенный на блоггере, имеет файл robots.txt по умолчанию, который выглядит примерно так:

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://businesswork9.blogspot.com/sitemap.xml

Этот код состоит из трех разделов. Давайте сначала изучим каждый из них, после этого мы узнаем, как добавить пользовательский файл robots.txt в блоги blogspot.

User-agent: Mediapartners-Google

Этот код предназначен для роботов Google Adsense, которые помогают им показывать более качественную рекламу в вашем блоге. Либо вы используете Google Adsense в своем блоге, либо не оставляете все как есть.

User-agent: *

Это для всех роботов, помеченных звездочкой (*). В настройках по умолчанию ссылки на ярлыки нашего блога индексируются поисковыми сканерами, что означает, что веб-сканеры не будут индексировать ссылки на страницы наших ярлыков из-за приведенного ниже кода.

Disallow: /search

Это означает, что ссылки, имеющие поиск по ключевым словам сразу после доменного имени, будут игнорироваться.

https://businesswork9.blogspot.com/search/

И если мы удалим Disallow: /search из приведенного выше кода, сканеры получат доступ ко всему нашему блогу, чтобы проиндексировать и просканировать весь его контент и веб-страницы.

Здесь Разрешить: / относится к домашней странице, что означает, что веб-сканеры могут сканировать и индексировать домашнюю страницу нашего блога.

Запретить конкретный пост

Теперь предположим, что если мы хотим исключить определенный пост из индексации, мы можем добавить строки ниже в коде.

Disallow: /yyyy/mm/post-url.html

Здесь yyyy и mm относятся к году публикации и месяцу публикации соответственно. Например, если мы опубликовали сообщение в 2019 году в марте, то мы должны использовать следующий формат.

Disallow: /2019/03/post-url.html

Чтобы упростить эту задачу, вы можете просто скопировать URL-адрес публикации и удалить название блога с самого начала.

Запретить конкретную страницу

Если нам нужно запретить определенную страницу, мы можем использовать тот же метод, что и выше. Просто скопируйте URL страницы и удалите из нее адрес блога, который будет выглядеть примерно так:

Disallow: /p/page-url.html

Sitemap: https://businesswork9.blogspot.com/sitemap.xml

Этот код относится к карте сайта нашего блога. Добавляя сюда ссылку на карту сайта, мы просто оптимизируем скорость сканирования нашего блога.

Это означает, что всякий раз, когда веб-сканеры сканируют наш файл robots.txt, они находят путь к нашей карте сайта, где присутствуют все ссылки наших опубликованных публикаций.

Сканеры найдут все наши сообщения.

Следовательно, есть больше шансов, что веб-сканеры сканируют все наши сообщения в блоге, не игнорируя ни одного.

Примечание . Эта карта сайта будет сообщать сканерам только о последних 25 сообщениях. Если вы хотите увеличить количество ссылок в вашей карте сайта, замените карту сайта по умолчанию на следующую. Это будет работать для первых 500 последних сообщений.

Sitemap:: https://businesswork9.blogspot.com/atom.xml?redirect=false&start-index=1&max-results=500

Если у вас есть более 500 опубликованных постов в вашем блоге, вы можете использовать две карты сайта, как показано ниже:

Sitemap:: https://businesswork9.blogspot.com/atom.xml?redirect=false&start-index=1&max-results=500

Sitemap:: https://businesswork9.blogspot.com/atom.xml?redirect=false&start-index=500&max

Добавление пользовательских роботов. Текст в Blogger

Теперь основная часть этого урока - как добавить собственный robots.txt в блоггер. Ниже приведены шаги, чтобы добавить его.

Зайдите в свой блог блогера.

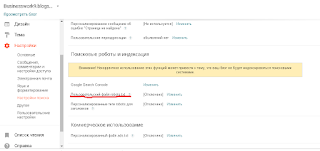

Перейдите в « Настройки» >> «Настройки поиска» ›› Сканеры и индексация ›› Пользовательский robots.txt ›› Редактировать ›› Да

Теперь вставьте свой код файла robots.txt в поле.

Нажмите на кнопку Сохранить изменения.

Вы сделали!

|

| blogspot.com нестандартные роботы TXT |

Вы можете проверить этот файл в своем блоге, добавив /robots.txt в конце URL вашего блога в веб-браузере. Например:

https://businesswork9.blogspot.com/robots.txt

При посещении URL-адреса файла robots.txt вы увидите весь код, который вы используете, в своем пользовательском файле robots.txt.

|

| Роботы TXT blogspot.com |

Заключительные слова!

Сегодняшнее полное руководство о том, как добавить собственный файл robots.txt в блоггер .

Я старался сделать этот урок максимально простым и информативным. Но все же, если у вас есть какие-либо сомнения или вопросы, не стесняйтесь спрашивать меня в разделе комментариев ниже.

Убедитесь, что не добавили никакого кода в ваши пользовательские настройки robots.txt, не зная об этом. Просто попросите меня разрешить ваши вопросы. Я расскажу вам все подробно.

Спасибо, ребята, что прочитали этот урок. Если вам понравилось, пожалуйста, поддержите меня в распространении моих слов, поделившись этим постом в своих профилях в социальных сетях. Удачного блога!